Street View è una piattaforma potente e versatile, utile ad esempio per visitare virtualmente un luogo prima di recarcisi, stando comodamente seduti di fronte al monitor. Questo grazie alle immagini panoramiche a 360 gradi assemblate dal gruppo di Mountain View, con l’ausilio di macchinari come le vetture Google Car o gli zaini Trekker equipaggiati con ben 15 obiettivi a differenti angolazioni.

L’esperienza offerta però potrebbe essere ancora più coinvolgente e immersiva, dando l’impressione di passeggiare senza in modo “flawless” (senza scatti) da un punto all’altro delle location immortalate. Lo dimostra il team della Cornell University al lavoro sul progetto DeepStereo. Il funzionamento è ben illustrato nel filmato dimostrativo in streaming di seguito.

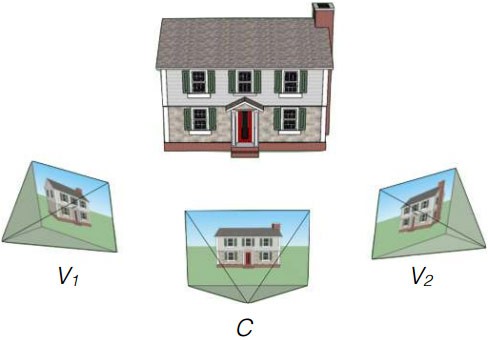

In breve, l’algoritmo realizzato prende i panorami di Street View vicini e ricrea i frame mancanti che li separano. Ne risulta, ad esempio, l’impressione di passeggiare in modo fluido all’interno di una stanza o per strada, anziché di fare un balzo lungo alcuni metri passando da una zona all’altra dell’ambiente, come avviene oggi su Street View. In altre parole, il software parte da due immagini scattate da punti distanti tra loro e ricrea tutte quelle intermedie. La tecnologia non è ancora perfetta, ma senza alcun dubbio ha un elevato potenziale.

L’elaborazione per creare artificialmente una singola immagine richiede una notevole potenza di calcolo, dovuta alla necessità di effettuare l’interpolazione su tutti gli elementi presenti nella scena. Stando ai primi test, con una workstation professionale si arriva ad impiegare il processore per una media di 12 minuti. Si tratta dunque di un processo lungo e complicato. L’efficacia è notevole negli spazi chiusi, mentre necessita di migliorie quando si ha a che fare con oggetti particolarmente dettagliati, ad esempio un albero pieno di foglie. Da precisare che Google, nonostante si occupi di Street View, non è in alcun modo coinvolto nel progetto.

/https://www.webnews.it/app/uploads/2015/07/street_view.jpg)

/https://www.webnews.it/app/uploads/2025/05/wp_drafter_1215152.jpg)

/https://www.webnews.it/app/uploads/2025/05/wp_drafter_1214903.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1213941.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1213570.jpg)