I datacenter sono edifici strutturati per ospitare grandi ammassi di server utili all’elaborazione o all’archiviazione di dati. Il lavoro di una tale mole di “potenza IT” implica però un effetto collaterale noto: la produzione di una forte quantità di calore che, moltiplicata per il numero di server utilizzati, rende difficile lo smaltimento efficiente dei flussi d’aria calda creatisi. In questo elemento risiede il valore di un datacenter: nella capacità di smaltire il calore creato, ma riuscendo a fare tutto ciò con il minor dispendio possibile di energia ulteriore. Ed è proprio nell’elemento centrale di un datacenter che l’ENI Green Data Center riesce a mettere a segno il punto più importante.

ENI Green Data Center – Struttura delle torrette

Fin dall’esordio è già infatti in archivio il record mondiale di efficienza. Per efficienza si intende il rapporto tra l’energia assorbita dall’impianto e l’energia utilizzata per il semplice funzionamento degli apparati informatici: il Green Data Center è in grado di arrivare ad un target PUE (Power Usage Effectiveness) pari a 1,2 superando l’attuale record mondiale di 1,27 (e con qualche, per ora ipotetico, margine ulteriore di miglioramento). L’obiettivo, così come esplicitamente dichiarato dall’Executive Vice President Information & Communication Technology, Gianluigi Castelli, da era quello di superare l’efficienza dei datacenter Google: obiettivo raggiunto.

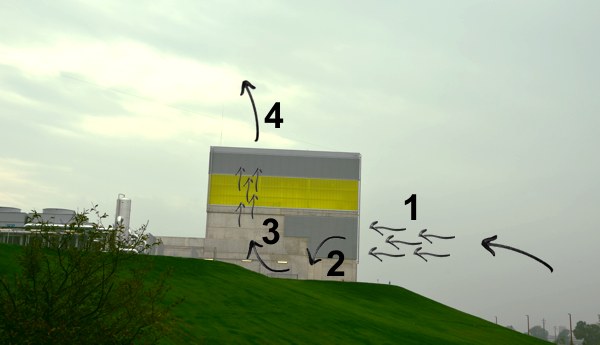

Il Green Data Center ha raggiunto tale livello di efficienza utilizzando una tecnologia estremamente comoda, diffusa e per certi versi innovativa: l’aria. La tecnica del “free-cooling“, infatti, consiste nell’utilizzare speciali torrette in cemento e acciaio come veri e propri polmoni in grado di “inspirare” aria dall’esterno, filtrarla, veicolarla in appositi percorsi e quindi “espirare”. L’aria in entrata è fredda e sporca, mentre l’aria in uscita è calda e pulita: migliaia di tonnellate di particolato vengono trattenute dai filtri del sistema, consentendo l’uso di aria depurata dalle polveri laddove i server necessitano di condizioni ottimali per poter garantire performance ed efficienza durature.

L’aria assorbita dall’esterno viene spinta verso i fori di uscita sia tramite la semplice differenza di pressione (il “tiraggio” è il medesimo di qualsiasi camino), sia per mezzo della forzatura rappresentata da speciali motori con pale a orientamento variabile: veri e propri ventilatori, insomma, che indirizzano il flusso dell’aria (secondo quanto dedotto da appositi studi di fluidodinamica computazionale) e garantiscono omogeneità di raffreddamento in tutto il locale contenente il cuore pulsante del datacenter.

La scelta di aspirazione “naturale” dell’aria tramite i camini, consente poi di utilizzare sistemi ventilazione di spinta a bassissima prevalenza (20PA), che muovono grandi masse d’aria (fino a 1,4ml di m3/h per ciascuna sala, cioè oltre 8ml di m3/h complessivi) ma con velocità dell’aria sempre molto basse (dell’ordine di 1-1,5 m/s), e quindi in grado di garantire elevatissime efficienze.

ENI Green Data Center – Il flusso di raffreddamento

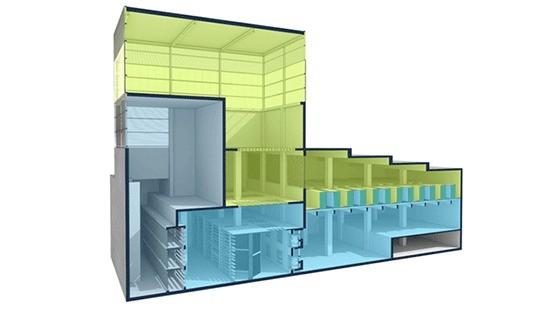

La separazione dei flussi dell’aria calda da quelli di aria fredda è alla base dell’efficienza energetica raggiunta: la compartimentazione del percorso compiuto dai volumi d’aria utilizzati è stata rigidamente progettata a tal fine, veicolando il freddo laddove sia più necessario per il raffreddamento dei sistemi.

Al Green Data Center abbiamo scelto di implementare in ciascuna sala un sistema di compartimentazione rigorosa dell’aria, ottenuto mediante strutture rigide di CAGE, che mantengono chiuso e separato il corridoio dell’aria fredda (su cui si affacciano le prese di aspirazione d’aria dei server), mentre di fatto il resto della sala costituisce il corridoio caldo, dove l’aria calda espulsa dai server viene veicolata per spinta, sia dei ventilatori che per effetto camino, verso la presa di espulsione sul percorso di uscita del camino.

C’è un aspetto fondamentale da tenere in considerazione, però: il luogo in cui è posizionato il datacenter. Ferrera Erbognone, sito ove Enipower ha la propria sede e dove ha dislocato anche il datacenter, è in piena pianura padana, nella campagna della Lomellina, in prossimità del 45esimo parallelo. Ciò significa temperature tipiche del nord Italia, con umidità tipiche del ventre del bacino del Po. L’umidità è un fattore superato poiché non incide in alcun modo sull’efficienza della struttura; il freddo invernale è un grosso aiuto per il raffreddamento dei sistemi; il caldo estivo è invece un problema. Quando l’aria “inspirata” è eccessivamente calda (i sistemi sono comunque progettati per lavorare in modo ottimale fino a 25 gradi centigradi), occorre intervenire con sistemi ulteriori di raffreddamento, una sorta di compendio necessario che si attiva soltanto nei casi in cui il free-cooling non sia sufficiente al buon funzionamento dei server. Tali circostanze sono state stimate in un 25% del tempo complessivo, lasciando il restante 75% ad un raffreddamento esclusivo tramite il sistema ad aria.

«Per assicurare il corretto raffreddamento dei sistemi, si rende necessario installare anche un sistema (ridondato) di chiller ad altissima efficienza, con torri evaporative, per garantire le prescritte condizioni d’esercizio per temperatura e umidità anche nelle giornate estive molto calde o in particolari situazioni ambientali in cui sarà richiesto il funzionamento “a chiuso”»: apposite vasche di acqua refrigerata a 9 gradi centigradi (vedi la mappa) potranno dunque intervenire in questi frangenti, assicurando continuità operativa al sistema in ogni condizione che il clima possa presentare.

/https://www.webnews.it/app/uploads/2013/10/650_raffreddamento.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1212787.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1212639.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1212452.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1212176.jpg)