Facebook vuole che i suoi bot non riconoscano soltanto i nostri volti, ma anche imitarli. L’allenamento del gigante tecnologico avviene tramite l’apprendimento automatico delle macchine, nutrite di immagini video, come spiegato dai ricercatori che stanno lavorando per Menlo Park.

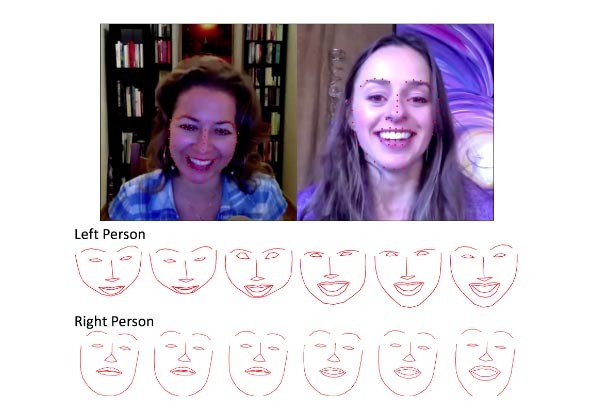

In un articolo, intitolato Learn2Smile: Learning Non-Verbal Interaction Through Observation, gli autori spiegano come stanno formando i bot: utilizzando una serie di video YouTube che riproducono conversazioni Skype in cui il volto di ogni partecipante sia ben visibile. Naturalmente questi video sono processati secondo criteri non umani, ciò che “interessa” alla macchina è individuare tutte quelle microespressioni associate a delle emozioni che consentano, spiegano nel report, di interpretare e persino prevedere le risposte emotive dell’utente. L’occhio umano le registra ma noi non ce ne accorgiamo, anche se la nostra mente le recepisce, così come tutti noi tradiamo le nostre emozioni con queste espressioni senza accorgercene.

Un esempio dell’analisi dei pattern da parte delle macchine, che alimentano l’intelligenza artificiale con la quale Facebook conta di realizzare dei bot che non solo riconoscano le emozioni degli utenti, ma le sappia riprodurre in realtà virtuale.

Il passo successivo è la costruzione di interfacce sempre più umane, conversazionali. Apprendendo questi modelli ripetitivi nei volti umani, il sistema di bot mostra reazioni che l’utente ritiene credibili perché somigliano alle sue. Pattern molto sottili, perciò, introdotti in modelli reattivi e predittivi. Facile immaginare le implicazioni enormi di questa nuova generazioni di bot, dall’ecommerce alla comunicazione, nel contesto delle interazioni uomo-macchina che diventerà cross-ambientale, dal sito web alle app fino alla realtà virtuale nella quale Facebook crede particolarmente e ha investito somme ingenti.

L’evoluzione del social è piuttosto nota e spiegata anche dai vertici e dallo stesso Zuckerberg: dal testo all’immagine, dal video alla VR, con applicazioni come Facebook Spaces, che permette ai partecipanti di interagire con gli avatar. I chat bot di Messenger, già esistenti, fra pochi anni sembreranno giochini per bambini.

/https://www.webnews.it/app/uploads/2017/09/espressioni-bot-facebook.jpg)

/https://www.webnews.it/app/uploads/2025/04/flux_image_1213636_1745488121.jpeg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1213589.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1213445.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1213218.jpg)