Si chiama Tivoli, e secondo indiscrezioni dovrebbe essere una nuova applicazione per l’apprendimento del linguaggio in sviluppo presso i laboratori di Google. Il sistema dovrebbe sfruttare un’intelligenza artificiale estremamente evoluta, in grado di replicare perfettamente il linguaggio umano e rendere così più naturali le conversazioni tra l’IA e gli utenti, e quindi anche l’insegnamento delle lingue. La app dovrebbe essere fruibile da computer, smartphone e tablet.

Per Tivoli, Google punta su LaMDA

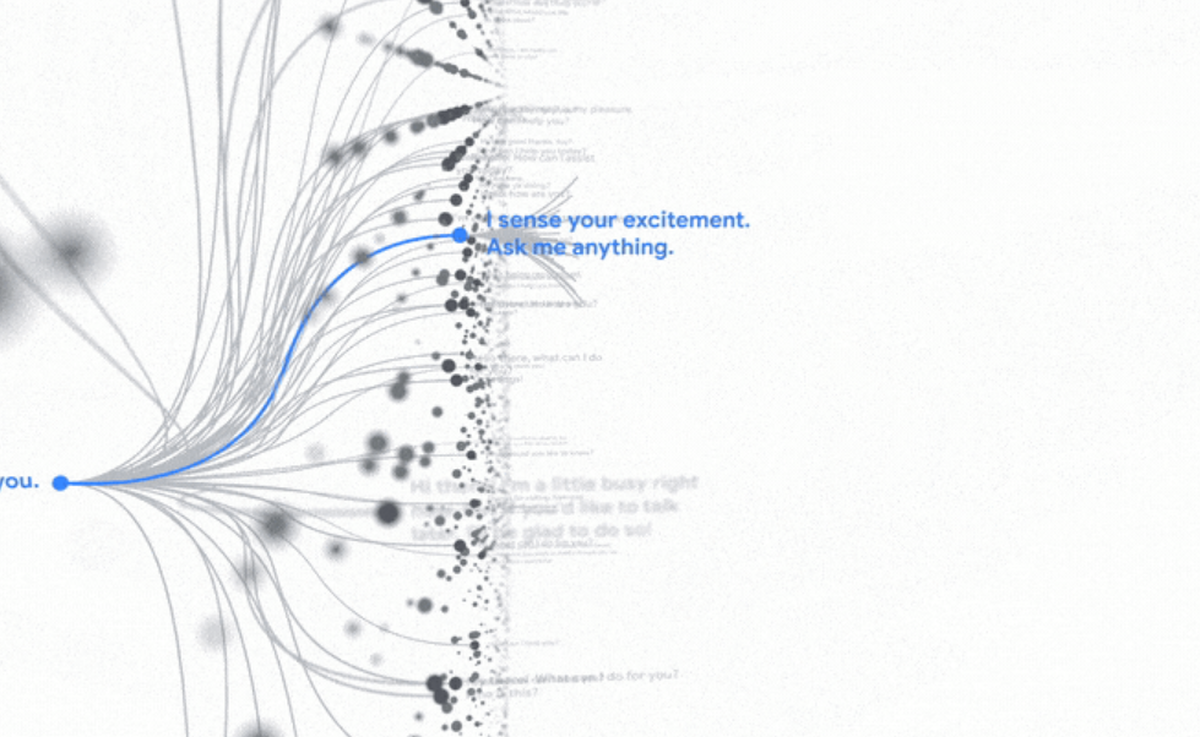

Tivoli dovrebbe essere sviluppato sulla base di LaMDA, un potente algoritmo per la comprensione del linguaggio naturale, presentato durante l’evento Google I/O 2021, la conferenza di Google dedicata agli sviluppatori. LaMDA, acronimo di Language Model for Dialogue Applications, rientra infatti nell’ambito di ciò che viene definito Natural Language Understanding (NLU), ovverosia la cognizione e interpretazione del linguaggio umano nell’elaborazione della comunicazione naturale nell’intelligenza artificiale, che si occupa della comprensione della lettura automatica.

Da questo punto di vista, LaMDA è in grado di rispondere perfettamente alle domande, utilizzando se necessario perfino delle battute, così da rendere un dialogo fluido e piacevole. Le capacità di conversazione di LaMDA sono state sviluppate per anni, come molti modelli linguistici recenti, tra cui BERT e GPT-3, è basato su Transformer, un’architettura di rete neurale che Google Research ha inventato e reso open-source nel 2017.

Quell’architettura produce un modello che può essere addestrato a leggere molte parole (una frase o paragrafo, per esempio), prestare attenzione a come quelle parole si relazionano tra loro e quindi prevedere quali verranno dopo. Ma a differenza della maggior parte degli altri modelli linguistici, LaMDA è stata addestrata al dialogo. Durante la sua formazione, ha raccolto molte delle sfumature che distinguono la conversazione aperta da altre forme di linguaggio. Una di queste sfumature è la ragionevolezza./https://www.webnews.it/app/uploads/2017/07/intelligenza.jpg)

Ecco perché l’azienda vuole ridurre al minimo i rischi di uno sfruttamento sbagliato dell’IA. Secondo Google il linguaggio artificiale potrebbe essere uno dei più grandi strumenti dell’umanità, ma in quanto tale può essere utilizzato in modo improprio. I modelli formati sul linguaggio possono propagare un uso improprio dello stesso, ad esempio interiorizzando i pregiudizi, rispecchiando i discorsi di odio o replicando informazioni fuorvianti. E anche quando la lingua su cui viene addestrato viene attentamente controllata, il modello stesso può ancora essere sfruttato male.

/https://www.webnews.it/app/uploads/2021/05/google-io-2021.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1213427.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1212961.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1212795.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1212170.jpg)