Mantenere operativa un’infrastruttura tanto complessa come quella che gestisce i servizi e le piattaforme di Google è dispendioso, sia dal punto di vista energetico che economico. Per questo il gruppo di Mountain View è impegnato ormai da oltre dieci anni nel tentativo di ridurre per quanto possibile i consumi, rendendo così i propri data center sempre più efficienti ed eco-friendly. L’ultimo passo nella giusta direzione è appena stato compiuto.

Il motore di ricerca lo annuncia oggi, con un post comparso sul blog ufficiale intitolato “Data center migliori grazie al machine learning”. La documentazione pubblicata affronta la questione in modo tecnico e approfondito, spiegando come è stato possibile sviluppare una sorta di rete neurale artificiale in grado di ottimizzare il funzionamento delle strutture. Riducendo il tutto a termini comprensibili anche per chi ha poca dimestichezza con algoritmi e modelli matematici, bigG ha trovato il modo di elaborare informazioni come l’energia consumata dai server, la temperatura dell’aria (che influisce direttamente sui sistemi di raffreddamento) e altri parametri, in modo da creare una previsione affidabile del PUE, ovvero del Power Usage Effectiveness.

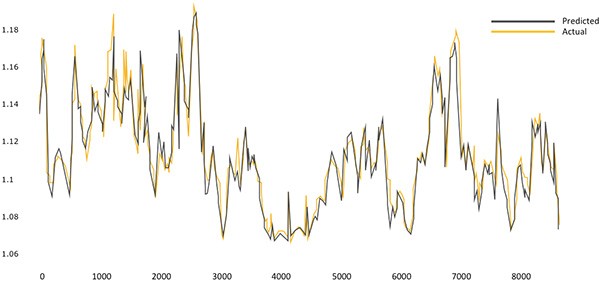

L’idea è balzata in testa a Jim Gao, non a caso soprannominato “Boy Genius”, ingegnere che fa parte del team di Google al lavoro sui data center. Grazie ad una previsione di questo tipo (l’affidabilità è pari al 99,6% circa, come testimonia il grafico allegato) è possibile ottimizzare i consumi, ad esempio rallentando il funzionamento degli impianti di raffreddamento quando non sono necessari. Accorgimenti come questo, adottati quotidianamente, alla lunga possono fare la differenza e generare benefici sia dal punto di vista economico che da quello energetico. Chi desidera approfondire la questione può scaricare e consultare un file PDF contenente tutte le informazioni tecniche.

/https://www.webnews.it/app/uploads/2014/05/data_center.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1213570.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1213427.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1212961.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1212795.jpg)