Un algoritmo creato e perfezionato da Google, Show and Tell, è in grado di attribuire una didascalia alle foto. Non si tratta di una tecnologia nuova, ma oggi il gruppo di Mountain View mostra i progressi effettuati e la precisione del testo generato automaticamente in base agli oggetti e ai soggetti riconosciuti all’interno delle foto. Una prova di forza per l’intelligenza artificiale di bigG.

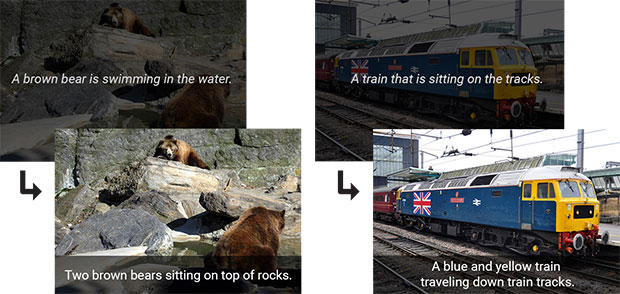

Si prendano gli esempi allegati di seguito. Le fotografie nella parte alta riportano le didascalie generate automaticamente in passato, sotto quelle attuali. Nella prima immagine si è passati da “Un orso bruno sta nuotando nell’acqua” a “Due orsi bruni sono seduti su delle rocce”, molto più in linea con quanto raffigurato. Nell’esempio di destra, invece, si è passati da “Un treno staziona sui binari” a “Un treno blu e giallo sta viaggiando lungo i binari ferroviari”, aggiungendo informazioni sul colore della locomotiva e su ciò che sta facendo. L’accuratezza del sistema, al momento, raggiunge il 93,9%.

I miglioramenti apportati da Google al sistema di intelligenza artificiale in grado di aggiungere didascalie alle foto

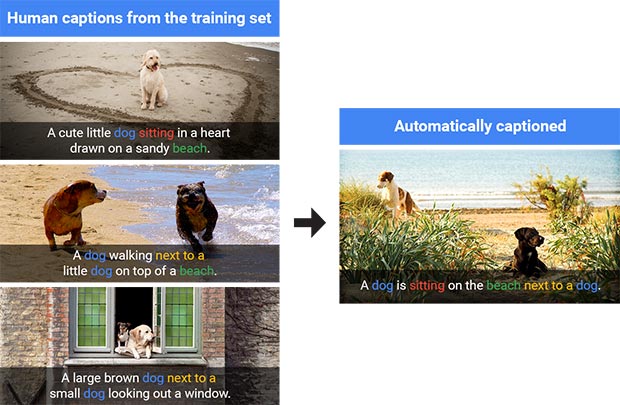

L’IA è stata istruita utilizzando didascalie scritte da persone in carne ed ossa, come mostra lo schema di seguito. Si prendono foto che raffigurano dei cani e le si etichetta con didascalie dettagliate. Poi, sulla base di queste informazioni, l’algoritmo è in grado di riconoscere l’animale nelle immagini, il luogo in cui si trova, gli oggetti che lo circondano e così via. Una tecnologia di questo tipo, che il gruppo di Mountain View ha reso open source, potrà un giorno tornare utile ad esempio nei software di editing fotografico, per migliorare l’esperienza di navigazione online degli utenti con problemi alla vista (tramite screen reader) e in numerosi altri modi.

Un cane è seduto su una spiaggia vicino ad un altro cane.

A sinistra alcune delle immagini impiegate per insegnare all’IA come generare le didascalie e a destra il risultato

/https://www.webnews.it/app/uploads/2016/09/caption1.jpg)

/https://www.webnews.it/app/uploads/2025/05/ChatGPT-google-chrome1.jpg)

/https://www.webnews.it/app/uploads/2025/05/wp_drafter_1215321.jpg)

/https://www.webnews.it/app/uploads/2025/05/wp_drafter_1215152.jpg)

/https://www.webnews.it/app/uploads/2025/05/wp_drafter_1214903.jpg)