Si apre un motore di ricerca, si digita una query, si genera una pagina con i risultati relativi ai termini specificati. Semplice, no? Non esattamente. Il processo che si innesca quando si preme Invio sulla tastiera e che porta a generare la SERP è complesso, fatto di algoritmi e statistiche, personalizzazioni e migliaia di righe di codice del tutto invisibili agli occhi di chi naviga. I link mostrati sul mio monitor, a parità di parole cercate, saranno con tutta probabilità differenti da quelli di chi sta leggendo questo articolo e certamente diversi per chi si connette dall’altra parte del mondo.

La Juve ruba?

L’introduzione di una feature come Instant, ovvero il completamento automatico dei termini di ricerca mentre ancora li si sta scrivendo, ha ridotto ulteriormente l’attesa necessaria per arrivare alle informazioni desiderate, ma al tempo stesso rischia di veicolare gli utenti verso le query più popolari. Un esempio: se apro Google e inizio a digitare “matteo renzi”, ho la possibilità di completare la query a mio piacimento oppure di scegliere una delle opzioni che vengono mostrate in automatico. Le prime puntano ai profili social dell’ormai ex Presidente del Consiglio, altre conducono al suo indirizzo email, altre ancora alla biografia e a scoprirne l’altezza.

I suggerimenti di Google Instant per la query “matteo renzi”

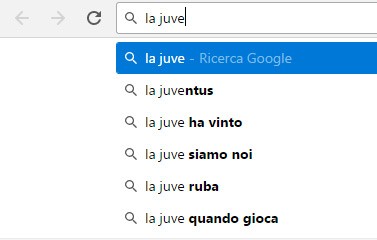

Fin qui, nulla di strano. Si passi ad un altro esempio, per capire come talvolta i suggerimenti forniti da bigG possano invece essere fonte di informazioni errate, parziali o quanto meno discutibili. Si faccia una prova digitando “la juve”. Ecco comparire “la juventus”, “la juve ha vinto”, “la juve siamo noi”, “la juve quando gioca”, ma anche “la juve ruba”. Un click e si apre una SERP che raccoglie sia i pareri di chi sostiene la tesi che di coloro che cercano di confutarla.

Google Instant suggerisce di cercare informazioni a proposito del tema “la juve ruba”

Una provocazione, ma utile per capire in che modo uno strumento come Instant, creato con l’obiettivo di semplificare e velocizzare il processo di ricerca, possa potenzialmente finire con l’influenzare la qualità e l’obiettività delle informazioni trovate da chi naviga. Certo, si può obiettare che la funzionalità può essere in qualsiasi momento disattivata dall’utente (basta selezionare “Non mostrare mai i risultati di Instant” tra le impostazioni personali), ma essendo abilitata di default, in quanti lo fanno?

Da questa riflessione prende vita (di nuovo, riportando in auge un argomento già trattato più volte in passato) un’analisi comparsa sulle pagine del Guardian. Gli esempi presi in considerazione sono “are jews” (“gli ebrei sono”), “are women” (“le donne sono”) e “are muslims” (“i musulmani sono”). Come si può immaginare, ai soggetti vengono affiancati da Instant aggettivi come “evil”, nel migliore dei casi. Secondo alcuni pareri raccolti dall’autrice dell’articolo Carole Cadwalladr, come quello di Robert Epstein, ricercatore di psicologia dell’American Institute for Behavioural Research and Technology, un comportamento di questo tipo finisce con l’influenzare l’opinione pubblica, contribuendo a generare visioni falsate su temi delicati e rischiando di creare tensioni. Una dimostrazione concreta: cercando “do blacks” (“i neri fanno”) compare il suggerimento “commit more crimes” (“commettono più crimini”).

La posizione di Google

È dunque responsabilità di Google intervenire evitando che il completamento automatico di una query possa veicolare l’utente verso pagine contenenti informazioni potenzialmente dannose o errate? Oppure spetta a chi naviga assumere finalmente la consapevolezza che la consultazione delle risorse Web è un processo di tipo attivo e che, come qualsiasi altro tipo di interazione, richiede una coscienza e cognizione? Il vero nodo da sciogliere è proprio questo: se un numero enorme di persone cerca “la juve ruba” sul motore di ricerca, è giusto che il gruppo di Mountain View intervenga per escludere il suggerimento dalle query di Instant? Questa la posizione ufficiale dell’azienda californiana.

I risultati delle nostre ricerche sono un riflesso di ciò che si trova sul Web. Questo significa che, a volte, contenuti online spiacevoli relativi a tematiche sensibili possono influire su ciò che compare nelle SERP per una specifica query. I risultati in questione non rappresentano le opinioni o le posizioni di Google. Come azienda, crediamo nel dare valore ad una varietà di prospettive, idee e culture.

Google processa 63.000 ricerche al secondo, 5,5 miliardi ogni 24 ore a livello globale. Tramite le richieste di takedown interviene rimuovendo dalle SERP i risultati che portano alla distribuzione non autorizzata di materiale protetto dal diritto d’autore e con l’introduzione del diritto all’oblio chiunque può chiedere che vengano eliminati dall’indicizzazione i link che puntano verso informazioni sensibili riguardanti la propria persona ritenute diffamanti o non corrette.

Attribuire ad una tecnologia implementata dal motore di ricerca la responsabilità di influenzare o addirittura manipolare un’opinione significa anzitutto deresponsabilizzare chi lo utilizza, partire dal presupposto che il fruitore delle informazioni non sia in grado di completare una query in maniera autonoma né di valutare in maniera razionale se i risultati proposti sono da considerarsi degni di essere consultati o meno. Si entra in un territorio scivoloso, dove la più che giustificata necessità di combattere piaghe come il razzismo e la discriminazione rischia di prevaricare l’altrettanto legittima libertà ad essere informati e sfociare in censura, anche quando le informazioni in questione non sono in linea con la propria visione o addirittura possono essere etichettate come deprecabili. Condannarle, però, non è un compito che spetta a Google.

/https://www.webnews.it/app/uploads/2016/12/motore-1.jpg)

/https://www.webnews.it/app/uploads/2025/03/wp_drafter_1210204.jpg)

/https://www.webnews.it/app/uploads/2025/02/wp_drafter_1209961.jpg)

/https://www.webnews.it/app/uploads/2025/02/wp_drafter_1209935.jpg)

/https://www.webnews.it/app/uploads/2025/02/wp_drafter_1209937.jpg)