L’obiettivo di chi sviluppa sistemi legati all’intelligenza artificiale è quello di arrivare a produrre algoritmi tanto complessi e affidabili da poter replicare in maniera fedele i processi cognitivi dell’essere umano, simulandone comportamenti relativi ad analisi e ragionamento. Uno dei nuovi progetti messi in campo da Google mira al riconoscimento del luogo in cui sono state scattate le immagini senza nessuna informazione descrittiva, di geolocalizzazione o tag.

Per capire di cosa si tratta è possibile partire da un esempio. Si pensi ad una fotografia in cui compaiono elementi fortemente caratterizzanti come la Torre Eiffel o la Statua della Libertà: già gli attuali sistemi sono in grado di riconoscere il monumento, per poi collocarlo in un punto ben preciso sulla mappa del pianeta. Se invece l’inquadratura non contiene riferimenti tanto chiari e conosciuti le cose si complicano. È qui che entrano in gioco deep learning e reti neurali. La tecnologia in questione si comporta proprio come un essere umano: cerca di capire in che lingua sono scritti eventuali cartelli stradali, osserva il tipo di vegetazione per ricondurlo ad una ben precisa area geografica, lo stile dell’architettura, la direzione del traffico (se la guida è a destra oppure a sinistra) e molto altro ancora. Tutti indizi utili a collocare una fotografia nello spazio.

Computer vision

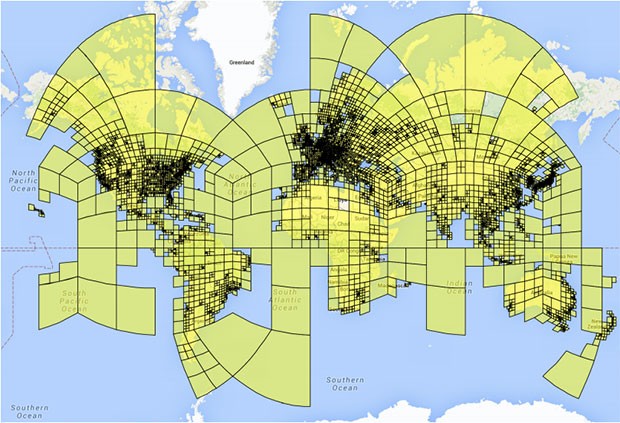

Il progetto è portato avanti da Tobias Weyand, un esperto di computer vision interno a Google. L’approccio utilizzato è unico nel suo genere: il primo step ha richiesto la divisione del mondo intero in circa 26.000 porzioni, dall’ampiezza variabile in base al numero di immagini disponibili per ogni area. Questo significa che le grandi città, fotografate con maggiore frequenza, sono rappresentate da settori più piccoli rispetto alle zone remote. Gli oceani e le regioni polari, per il momento, non sono inclusi nel database. Successivamente il team ha creato un enorme archivio con oltre 126 milioni di foto collocandole esattamente nella posizione in cui sono state scattate, sfruttando i dati Exif inclusi.

Le oltre 26.000 zone in cui è stato diviso il mondo dal team di PlaNet

La rete neurale PlaNet

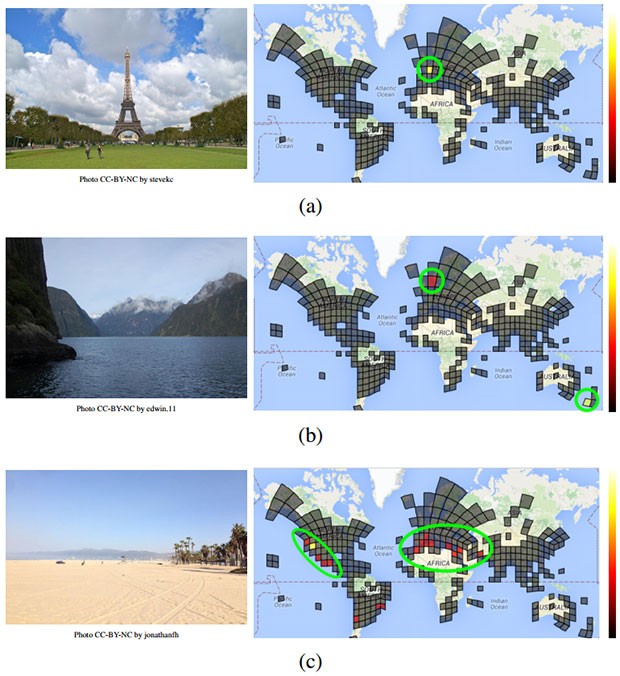

La rete neurale, chiamata PlaNet si occupa proprio di confrontare una qualsiasi immagine di cui non si conosce la provenienza con i tratti che caratterizzano le foto presenti nel database, così da ricondurla ad una collocazione geografica ben precisa. I primi test mostrano risultati incoraggianti, anche se mettono in evidenza la necessità di migliorare l’efficacia degli algoritmi impiegati: basandosi su un totale pari a 2,3 milioni di immagini, il sistema è stato in grado di localizzarne correttamente il 10,1% indicando la città. Inoltre, nel 3,6% dei casi è stato in grado di determinare anche la via esatta. La percentuale di successo cresce al 28,4% se si chiede solamente la nazione e al 48% se ci si accontenta di sapere il continente.

La geolocalizzazione delle immagini tramite il sistema PlaNet di Google

Intelligenza artificiale vs. essere umano

Per dimostrare l’efficacia della tecnologia, Weyand e i suoi collaboratori lanciano una sfida: sulle pagine del sito GeoGuessr vengono mostrate immagini prelevate casualmente da Street View, chiedendo di indicarne la posizione geografica. Questi i risultati.

In totale, PlaNet ha vinto 28 dei 50 round, con un errore medio nella localizzazione pari a 1.131,7 Km, mentre quello attribuito agli umani è stato di 2.320,75 Km. L’esperimento mostra che le performance del sistema sono superiori rispetto a quelle dell’uomo nel geolocalizzare le fotografie di Street View.

Il vantaggio della tecnologia, in questo caso, è rappresentato dal fatto che potendosi basare su un archivio di immagini tanto vasto, PlaNet ha “visitato” pressoché qualsiasi location del mondo. Altrettanto interessante il fatto che il sistema funzioni in maniera piuttosto efficace anche per le fotografie realizzate ambienti indoor, a patto che facciano parte di un album in cui sono presenti anche scatti in ambienti esterni.

PlaNet è in grado di associare un’immagine al luogo in cui è stata scattata

Ciò che rende il progetto ancora più innovativo è il suo peso in termini di codice: il modello richiede solo 377 MB, un quantitativo di memoria disponibile anche su un tradizionale smartphone. Una delle applicazioni che il gruppo di Mountain View potrebbe avere in cantiere per sfruttare la tecnologia riguarda la localizzazione delle immagini gestite tramite il servizio Google Foto.

/https://www.webnews.it/app/uploads/2016/02/planet.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1213570.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1213427.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1212961.jpg)

/https://www.webnews.it/app/uploads/2025/04/wp_drafter_1212795.jpg)